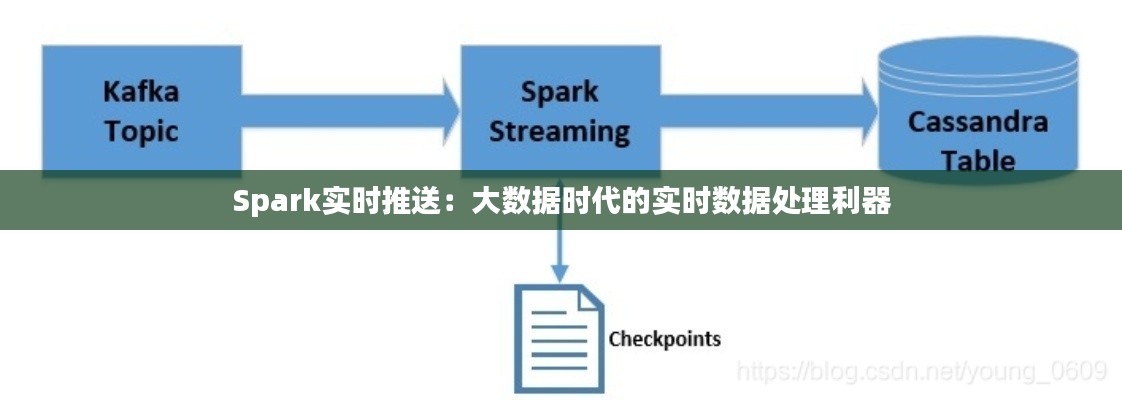

标题:Spark实时推送:大数据时代的实时数据处理利器

引言

在当今的大数据时代,实时数据处理能力已经成为企业竞争的关键。随着互联网技术的飞速发展,用户对数据实时性的要求越来越高。Spark作为一款强大的分布式计算框架,以其高效的实时数据处理能力,成为了大数据领域的热门选择。本文将深入探讨Spark实时推送的特点、应用场景以及在实际项目中的实施方法。

Spark实时推送概述

Spark实时推送(Spark Streaming)是Apache Spark的一个组件,它允许开发者在Spark平台上进行实时数据处理。Spark Streaming能够处理来自各种数据源的数据,如Kafka、Flume、Twitter等,并以流的形式进行实时处理。以下是Spark实时推送的几个关键特点:

- 高吞吐量:Spark Streaming能够以每秒数百万条记录的速率处理数据流。

- 容错性:Spark Streaming在处理数据流时,能够自动处理节点故障,保证数据处理的连续性。

- 易用性:Spark Streaming与Spark的其他组件(如Spark SQL、MLlib等)无缝集成,使得开发者能够方便地使用Spark生态系统中的各种工具。

- 弹性:Spark Streaming能够根据数据负载自动调整资源,以适应不同的处理需求。

Spark实时推送的应用场景

Spark实时推送在多个领域都有广泛的应用,以下是一些典型的应用场景:

- 社交网络分析:实时监控用户行为,分析用户兴趣,为用户提供个性化的推荐。

- 金融市场监控:实时分析市场数据,预测市场趋势,为投资者提供决策支持。

- 物联网数据监控:实时处理物联网设备产生的数据,监控设备状态,优化设备性能。

- 日志分析:实时分析服务器日志,监控系统性能,及时发现并解决问题。

Spark实时推送的实施方法

以下是使用Spark实时推送进行实时数据处理的基本步骤:

- 数据源接入:首先需要确定数据源,如Kafka、Flume等,并配置相应的数据源连接。

- 数据流处理:使用Spark Streaming API创建一个数据流,并定义数据处理逻辑,如过滤、转换、聚合等。

- 输出结果:将处理后的数据输出到目标系统,如数据库、文件系统或实时分析系统。

- 监控与优化:实时监控数据处理的性能,根据监控结果调整处理逻辑和资源分配。

案例研究:实时电商推荐系统

以下是一个使用Spark实时推送构建实时电商推荐系统的案例:

- 数据源:使用Kafka作为数据源,实时收集用户在电商平台上的浏览、购买等行为数据。

- 数据处理:使用Spark Streaming对数据进行实时处理,包括用户行为分析、商品关联规则挖掘等。

- 推荐生成:根据用户的历史行为和实时行为,生成个性化的商品推荐。

- 结果输出:将推荐结果实时推送给用户,提高用户满意度和平台转化率。

结论

Spark实时推送作为大数据时代的重要数据处理工具,具有高效、稳定、易用的特点。通过Spark实时推送,企业可以实现对海量数据的实时处理和分析,从而为用户提供更加精准的服务,提高业务竞争力。随着技术的不断发展和应用场景的拓展,Spark实时推送将在未来发挥更加重要的作用。

转载请注明来自台州大成电梯有限公司,本文标题:《Spark实时推送:大数据时代的实时数据处理利器》

浙ICP备2021033100号-1

浙ICP备2021033100号-1