标题:Kafka:揭秘其实现近实时数据处理的核心机制

什么是Kafka?

Kafka是一个由LinkedIn开发,目前由Apache软件基金会维护的分布式流处理平台。它最初被设计用于LinkedIn的日志收集和流处理系统,后来逐渐发展成为一个广泛用于大数据处理、实时分析、消息队列等场景的解决方案。Kafka的核心特性之一就是其能够提供近实时的数据处理能力。

分布式架构

Kafka采用分布式架构,这意味着它可以在多个服务器上运行,并且能够处理大规模的数据流。这种架构设计使得Kafka具有以下几个关键优势:

1. 高吞吐量:由于Kafka可以水平扩展,即通过增加更多的服务器来提高处理能力,因此它能够处理极高的数据吞吐量。

2. 可靠性:Kafka通过副本机制确保数据的可靠性和容错性。每个主题(Topic)的数据都会在多个服务器上存储多个副本,即使某些服务器出现故障,数据也不会丢失。

3. 可伸缩性:Kafka可以无缝地扩展其存储和处理能力,这使得它能够适应不断增长的数据量和用户需求。

日志收集与存储

Kafka的核心功能之一是日志收集。它可以将来自不同源的数据(如应用程序日志、服务器事件、用户行为等)收集到一个中心化的存储系统中。这种集中式存储使得数据可以轻松地被查询、分析和处理。

1. 高效的数据写入:Kafka使用了一种称为“日志”的数据结构来存储数据。这种结构允许Kafka以极高的速度写入数据,这对于实时数据处理至关重要。

2. 持久化存储:Kafka将数据持久化存储在磁盘上,这意味着即使服务器发生故障,数据也不会丢失。

3. 高效的数据读取:Kafka支持高效的顺序读取,这使得它可以快速地处理大量数据。

消息队列与流处理

Kafka不仅可以作为日志收集系统,还可以作为消息队列和流处理平台。这使得Kafka在处理实时数据时具有以下优势:

1. 解耦系统:通过使用Kafka作为消息队列,可以将数据的生产者和消费者解耦,从而提高系统的灵活性和可维护性。

2. 实时数据处理:Kafka能够以毫秒级的延迟处理数据,这使得它非常适合实时数据处理和分析。

3. 批处理与实时处理:Kafka支持同时进行批处理和实时处理,这使得它可以满足不同类型的数据处理需求。

实现近实时的关键机制

Kafka之所以能够实现近实时的数据处理,主要归功于以下几个关键机制:

1. 分区(Partitioning):Kafka将每个主题的数据分割成多个分区,每个分区可以独立地被消费,从而提高了数据处理的速度和并发性。

2. 偏移量(Offset):Kafka使用偏移量来标识消息在分区中的位置,这使得消费者可以精确地追踪其消费进度,即使在断开连接后也能从上次消费的位置继续消费。

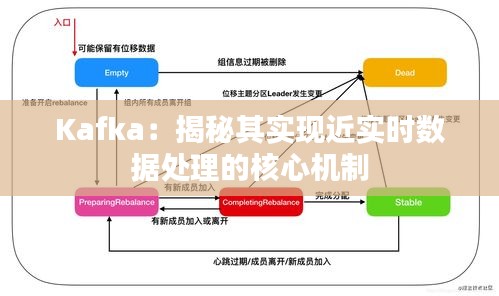

3. 消费者组(Consumer Groups):Kafka允许多个消费者实例组成一个消费者组来共同消费一个主题的数据,从而提高了数据处理的并行度。

4. 高效的序列化与反序列化:Kafka使用高效的序列化库来处理数据的序列化和反序列化,这减少了数据处理的延迟。

总结

Kafka通过其分布式架构、高效的日志收集与存储、消息队列与流处理能力,以及一系列关键机制,实现了近实时的数据处理。这使得Kafka成为大数据和实时分析领域的一个强大工具,广泛应用于各种场景,从日志收集到实时推荐系统,从事件流处理到数据监控。随着技术的不断发展和应用场景的不断拓展,Kafka将继续发挥其重要作用。

转载请注明来自台州大成电梯有限公司,本文标题:《Kafka:揭秘其实现近实时数据处理的核心机制》

浙ICP备2021033100号-1

浙ICP备2021033100号-1